Obraz z filmu „Gry wojenne” (1983 r.) reż. John Badham

Obraz z filmu „Gry wojenne” (1983 r.) reż. John BadhamDziś będzie nietypowo, bo w formie rozmowy z Red. Łukaszem Maziewskim, który znany jest z tego, iż nie przeszkadza pytaniami. Tym razem nie tylko nie przeszkadzał, ale zadawał niezmiernie ważne.

Zacznijmy z „wysokiego C”. Czy sztuczną inteligencję (Artificial Intelligence – AI) da się postawić np. przed Międzynarodowym Trybunałem Karnym za zbrodnie wojenne?

Nie da się. Tylko człowiek może ponieść odpowiedzialność karną.

Człowiek? Czy samoświadomy, rozumny byt, świadom konsekwencji swoich czynów?

Podmiot, a nie przedmiot. Koncepcja dobra i zła, moralności, to twory ludzi i dla ludzi.

Jak postawić system przed sądem? Skoro nie da się wirtualnie osądzić Putina czy Al Bashira, ludzi z krwi i kości, to jak osądzić byt całkowicie wirtualny?

To pytanie wysoce teoretyczne ale: uznajmy, iż opracowaliśmy sztuczną inteligencję. W pełni wykształcony, świadomy byt. Ładujemy takie AI do drona, który np. spuszcza Hellfire’a na wiochę gdzieś w południowym Sudanie. Kto odpowie za ewentualne konsekwencje stanowiące zbrodnię wojenną?

Twórca systemu, osoba, która zdecydowała o jego wdrożeniu, dowódca, który podjął decyzję u użyciu.

Poza tym AI to nie autokreacja. To twór człowieka. Więc to człowiek odpowiada za jej użycie.

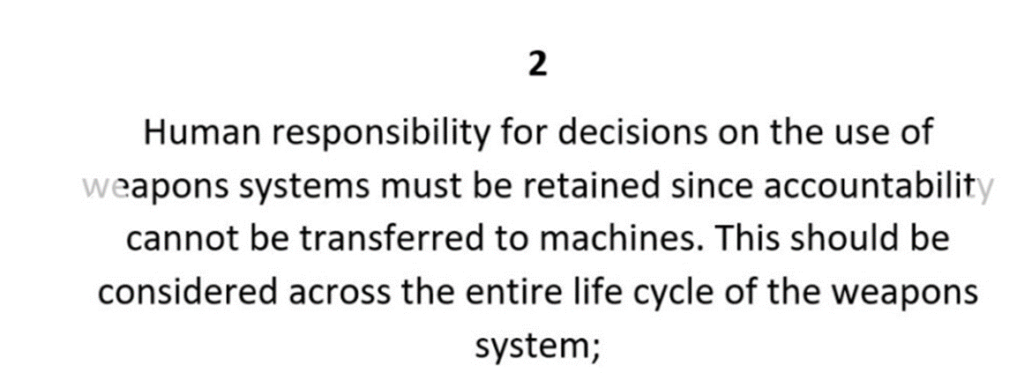

Sprawcą zabójstwa z użyciem broni palnej jest człowiek, a nie pistolet. I stąd dążenie do zapewnienia mechanizmów gwarantujących odpowiedzialność twórców/decydentów/dowódców, o których mowa między innymi w 11 wytycznych opracowanych przez Grupę Rządowych Ekspertów (Group of Governmental Experts – GGE) przy UNODA. Stąd postulat, iż odpowiedzialność nie może być delegowana na maszyny. Zasady 2,3, 4 GGE. Druga zasada GGE to de facto zakaz tworzenia systemów „man out-of-the-loop”, czyli takich, w których ludzka interwencja nie ma wpływu na proces decyzyjny prowadzony przez system autonomiczny.

Gorzej, jeżeli to się wyrwie spod kontroli.

Jak SkyNet…? Albo jak Joshua z „Gier wojennych”? Z Joshuą było trochę inaczej. Tam „maszyna” – powiedzmy, ze odzwierciedlenie fantazji scenarzystów na temat tego, jak będzie „wyglądać” sztuczna inteligencja w pewnym sensie okazała się „rozsądniejsza” od jej twórców.

Joshua „wiedział”, iż wojny jądrowej nie da się wygrać.

A strange game. The only winning move is not to play. How about a nice game of chess?

Wiedział to też twórca Joshuy, prof. Falken.

Ale mimo to, zaprogramował system tak, by za wszelką cenę poszukiwał on rozwiązania nierozwiązywalnego problemu.

A co z prawami robotyki Asimova?

Cóż. Szlachetne, ale martwe. Ich wdrożenie i przestrzeganie uniemożliwiłoby jakiekolwiek wojskowe zastosowanie „robotów” czy AI.

No właśnie. Stworzenie i wprowadzenie AI do wojska no właśnie. Zmieni podejście do walki czy nie?

Już zmieniło. I wciąż zmienia. Robota nie będzie żal wysłać na misję, choćby i samobójczą.

No i jeszcze kwestia kosztów. Ile kosztuje stworzenie sztucznej inteligencji? Mówi się, iż wyszkolenie pilota nowoczesnego samolotu bojowego to miliony USD…

Z tej perspektywy relatywnie niewiele. Jak wspomniał Pan Płk Zięć w roznowie z z Panem – „Man-machine-mission.” Wszystko to koszty. A teraz wyeliminujmy z bilansu człowieka. Rachunek zysków i strat zmienia się diametralnie i o to w tym chodzi. Zmniejszamy ryzyko, na jakie narażeni są żołnierze, piloci, kierując do walki systemy bezzałogowe lub autonomiczne. Tylko AI i systemy autonomiczne jeszcze nie są w stanie całkowicie zastąpić człowieka. A gdy już będą w stanie, to nie powinny.

Nie mogą zastąpić człowieka, bo póki co nie potrafią szacować ryzyka. Bo nie da się (na razie?) replikować inteligencji emocjonalnej.

A czemu nie powinny całkowicie zastąpić człowieka?

Bo normy etyczne są ludzkie z natury. Można maszynę „nauczyć” jak odróżniać nieuzbrojonego cywila od kombatanta albo kombatanta zdolnego do walki od tego, który jest hors de combat. Można 'nauczyć” maszynę jak szacować proporcjonalność w danych okolicznościach i czy tzw. straty niezamierzone (collateral damage) nie będą nadmierne w stosunku do korzyści wojskowej. Może choćby oszacuje proporcjonalność lepiej i szybciej niż człowiek, choć nie istnieje matematyczny wzór, wszystko jest względne i zależne od okoliczności, choćby tego, jak istotny jest cel. Ale takie algorytmy moim zdaniem da się opracować. Natomiast nie da się „nauczyć” maszyny zasady humanitaryzmu, czyli zakazu powodowania nadmiernych obrażeń lub zbędnego cierpienia. Co ciekawe, raport HRW pt. „Losing humanity. The case against killer robots”, w ogóle nie porusza zasady humanitaryzmu (humanity).

A jak „nauczyć” maszynę jaki poziom cierpienia jest dopuszczalny (niezbędny), jeżeli koncepcja cierpienia jest inherentnie związana z życiem i odczuwaniem?

Robot Haweha (Samsung) SGR-1 w trakcie testów.

Robot Haweha (Samsung) SGR-1 w trakcie testów.Mnóstwo problemów, przede wszystkim…. etycznych.

Rozwiążemy kilka, potencjalnie tworząc tysiące…

Zawsze będzie można powiedzieć, iż „system wymknął się spod kontroli”.

To nie będzie żadna wymówka. Wystarczy nie tworzyć takich systemów.

A co jeżeli taki system powstanie. I w pewnym momencie „postanowi” nie wykonać polecenia człowieka, zamiast tego, korzystając z zaimplementowanych protokołów uczenia maszynowego, opracować algorytmy, dzięki którym obroni się przed interwencją ludzkiego operatora?

Mówimy o przyszłości. Nie jestem w stanie ocenić, na ile odległej, ale w tej chwili nie istnieją jeszcze tak zaawansowane „protokoły” uczenia maszynowego, by maszyny stały się „mądrzejsze”, „sprytniejsze” od swoich twórców. Rozwiązaniem tego problemu ma być teoria przyjaznej sztucznej inteligencji Yudkowsky’ego: implementacja altruizmu. Najważniejsze jednak, by w takiej sytuacji był przysłowiowy „kill switch” – czy to w formie określonej linii kodu, czy fizyczny, umożliwiający przerwanie procesów mogących zagrozić ludzkości.

Czyli popełniamy błąd?

Nie, dopóki człowiek pozostaje co najmniej „na pętli”, czyli w każdej chwili może przerwać atak prowadzony przez maszynę. Nie da się zatrzymać postępu technologicznego, ważne, by mieć kontrolę nad jego rezultatami i nie cofnąć się do epoki telegrafu…